Zapomniane aktualizacje algorytmu Google cz.3

Zmiany w algorytmie wyszukiwarki mają wpływ na funkcjonowanie przedsiębiorstw na całym świecie. Należy jednak pamiętać, że dla Google priorytetem nie są właściciele witryn, które walczą między sobą o pozycje w SERP, tylko użytkownicy wpisujący zapytania. Właśnie dlatego celem ogromnej liczby zmian jest zapewnienie odbiorcy wyników będących jak najbardziej precyzyjną odpowiedzią na jego pytanie.

W związku z tym duża część wprowadzanych zmian pozostaje tajemnicą. W niektórych przypadkach nawet sam fakt wypuszczenia update’u nie zostaje ujawniony. Zdarza się także, że webmasterzy nie wierzą słowom pracowników Google lub nie zgadzają się z nimi w kwestii interpretacji czy dane modyfikacje algorytmu można nazwać aktualizacją. Gdyby firma ujawniała szczegóły dotyczące wprowadzanych modyfikacji, mogłoby to prowadzić do nadużyć, mających na celu uzyskanie wysokiej pozycji poprzez oszukanie algorytmu. Właśnie takie update’y, odnośnie których mamy niewiele informacji, omówimy w trzeciej części cyklu, przedstawiającego zapomniane aktualizacje algorytmu Google.

1. Aktualizacja Allegra

1. Aktualizacja Allegra

Nazwa tej aktualizacji pochodzi od włoskiego słowa oznaczającego „lekki”. Zmiana została wprowadzona między 2 a 8 lutego 2005 roku. Jej działanie nie zostało potwierdzone, dlatego możemy opierać się jedynie na spekulacjach.

Najpopularniejsza teoria dotycząca update’u Allegra głosi, że dzięki niej wyszukiwarka zaczęła lepiej odróżniać spontaniczne linki od tworzonych w sztuczny sposób. Po jej wprowadzeniu naturalne odnośniki miały być nagradzane. Taka teza była bardzo wiarygodna, zwłaszcza patrząc na dotychczasową historię modyfikacji algorytmu. Wielu webmasterów nadal uważa, że update Allegra był początkiem pracy nad rozpoznawaniem podejrzanych linków. Pojawiły się również podejrzenia, że aktualizacja uderza także w inne spamerskie techniki np. duplikaty treści. Tego typu spekulacje były skutkiem obserwacji, usunięcia z indeksu witryn zawierających znaczne ilości zduplikowanych treści.

Update miał wpływ także na LSI, czyli takie frazy, które swoim znaczeniem pomagają algorytmowi zrozumieć tematykę tekstu. W ten sposób, jeśli w tekście, którego tematem jest zamek, użyjemy sformułowań takich jak „błyskawiczny”, „do kurtki”, czy „do samodzielnego wszycia” Google będzie w stanie „zrozumieć” o jaki rodzaj zamka nam chodzi.

Niestety żadna z teorii nigdy nie została potwierdzona przez Google. Chociaż Matt Cutts zabrał głos w tej sprawie. Stwierdził, że zmiany, które zaszły w indeksie były spowodowane wprowadzeniem znacznika nofollow miesiąc wcześniej. Wielu ekspertów nie wierzy w jego słowa, uważając, że znacznik nie mógł wywołać aż takiego przetasowania.

2. Aktualizacja Burbon

2. Aktualizacja Burbon

Nazwa tej aktualizacji algorytmu – Burbon, wzięła się do słynnej ulicy Bourbon Street w Nowym Orleanie. Właśnie tam odbywała się konferencja WMW Webmaster Conference.

W maju 2005 roku GoogleGuy opublikował poradę dla specjalistów zajmujących się SEO. Zasugerował im, by przez kilka dni nie sprawdzali wyników swoich stron internetowych, ponieważ duże zmiany będą nieustannie odmieniać SERP. Żartobliwie stwierdził, że wprowadzone zostanie 3,5 usprawnienia wpływającego na jakość wyszukiwania. Podkreślił przy tym, że część, którą określa jako 0,5 zmiany wywrze ogromny wpływ na wyniki.

4 czerwca, GoogleGuy dostarczył informację dotyczącą tajemniczej połowy zmiany. Stwierdził, że nie była ona modyfikacją algorytmu. Obejmowała działania będące odpowiedzią na zgłoszenia stron spamerskich lub zawierających treści przeznaczone dla dorosłych. Aktualizacja miała odfiltrowywać tego typu strony z SERP.

Update był wymierzony w zduplikowane treści, zarówno te mieszczące się w obrębie jednej strony, jak i powtarzające się na różnych witrynach. Pod tym względem kontynuował działanie update’u Allegra. Oba warianty duplicate content zostały potraktowane jako nieuczciwe działanie, mające wpłynąć na pozycję strony w rankingu. Dzięki aktualizacji Google był w stanie rozpoznać DC nawet wtedy, gdy treści nie były całkowicie identyczne.

Allegra sprawiła także, że algorytm nauczył się lepiej rozpoznawać linki niepowiązane tematycznie. W tym przypadku strona mogła być gorzej oceniana, jeśli znaczna ilość linków do niej nie była powiązana tematycznie. Celem update’u były również farmy linków oraz strony, których jedynym zadaniem było linkowanie do witryny i podnoszenie jej rankingu.

3. Aktualizacja Gilligan

3. Aktualizacja Gilligan

Update Gilligan jest znany także jako “False Alarm”. We wrześniu 2005 roku wielu webmasterów zauważyło znaczne zmiany w SERP. Tak duże przetasowania wskazywały na jakąś modyfikację algorytmu. W sprawie zabrał głos Matt Cutts, który oficjalnie stwierdził, że aktualizacji nie było, a webmasterzy zaobserwowali jedynie zwykły taniec Google. Twierdził, że był on wywołany przez rutynowe działania firmy np. przeprowadzany raz na trzy miesiące eksport danych.

Mimo zdecydowanej wypowiedzi pracownika Google, wielu webmasterów nadal się z nim nie zgadza odnośnie ostatecznej interpretacji. Wszystko zależy od tego, co rozumiemy przez aktualizację. Dla osób, dla których aktualizacja nie musi stanowić zmiany algorytmu, może być nim tylko przetasowanie w SERP, Gilligan był aktualizacją.

Na forum WebMasterWorld, na którym omawiane są wszelkie zmiany, nazwę tematu dotyczącego update’u Gilligan zmieniono na False Alarm. Mimo wszystko nadal są osoby, które uważają, że nie zasługuje na miano update’u.

Ponadto, z wypowiedzi Cuttsa dowiadujemy się, że chociaż indeks jest aktualizowany na bieżąco, wiele innych rzeczy zmienia się raz na miesiąc, co jest cenną informacją, uchylającą rąbka tajemnicy na temat pracy wyszukiwarki.

4. Aktualizacja Buffy

4. Aktualizacja Buffy

Swoją nazwę otrzymał w hołdzie dla Vanessy Fox, która była pracowniczką Google, jednak postanowiła odejść z firmy. Ze względu na to, że prywatnie była wielką fanką serialu Buffy the Vampire Slayer, postanowiono uhonorować ją w ten sposób. Bardzo często określa się go jako update honorowy. Podobnie jak Gilligan, w opinii Matta Cuttsa Buffy nie jest updatem. Wyszedł w czerwcu 2007 roku.

Matt Cutts podkreślił, że lato to najlepszy czas, by wprowadzać update’y, jednak nie uważa by Buffy była jednym z nich. Według niego aktualizacje to tylko takie modyfikacje, które mają miejsce w algorytmie i zmieniają wagę poszczególnych czynników rankingowych. Chociaż przyznał, że nastąpiły pewne zmiany, to zaznaczył, że teorie webmasterów są nieprawdziwe. Ten tajemniczy komentarz był jedynym rąbkiem tajemnicy, który firma uchyliła na temat wprowadzonych zmian.

Zmiany, które w tamtym czasie zaszły w SERP były bardzo duże. Z tego względu wielu webmasterów uznało, że musi to być aktualizacja algorytmu. Niektórzy spekulowali, że dotyczy ona jednowyrazowych zapytań long tail, dlatego w ich przypadku znaczne zmiany pozycji nie są jednoznaczną wskazówką.

5. Aktualizacja Vince

5. Aktualizacja Vince

W lutym 2009 roku wyszła aktualizacja, która według ekspertów dała przewagę dużym i znanym brandom. Aktualizacja Vince dokonała zmian w wielu dziedzinach i obejmowała frazy dotyczące np. odzieży, piwa, ubezpieczeń, zabawek, czy baterii. Dzięki niej znacząco zyskały marki, które są znane z działalności offline i powszechnie wiązane z danymi produktami.

Od tej pory, po wpisaniu zapytania „bilety samolotowe”, wysoko w SERP widzieliśmy witrynę American Airlines, Delta Air Lines czy Northwest Airlines, czyli dużych lotniczych. Taka zmiana wywołała niemałe oburzenie u osób, które uważały, że update daje znanym markom niesprawiedliwą przewagę.

Warto jednak popatrzeć na to nieco inaczej – znane brandy cieszą się dużym zaufaniem, mają na swoich stronach wartościowy content oraz wiarygodne informacje. Posiadają zatem witryny, które warto wyświetlić wysoko w SERP.

Eric Schmidt stwierdził, że takie działanie stało się korzystne, ponieważ internet przepełnia się fałszywymi informacjami, w związku z tym warto promować wiarygodne źródła. W tym przypadku brandy stanowią bardzo przydatną wskazówkę.

Ponadto wprowadzenie aktualizacji Vince sprawiło, że bardziej opłacalne stało się korzystanie z tzw. efektu surround. Jest to technika marketingowa, która opiera się na jednoczesnym wykorzystaniu kilku form reklamy. Dzięki temu użytkownik bardzo często spotyka się z marką, zapamiętuje go i zaczyna traktować jak coś znanego i zaufanego.

6. Aktualizacja Fantom (Phantom)

6. Aktualizacja Fantom (Phantom)

Bardzo często tę aktualizację określa się również jako Phantom 2, ponieważ nie była pierwszą, podczas której Google dokonał znacznych zmian w SERP, nie udzielając na ten temat żadnych informacji. Update wszedł w życie 9 maja 2013 roku i swoim działaniem objął głównie serwisy informacyjne. Wiele z nich spadło w rankingu, jednak były również takie, które zyskały. Wśród tych, które utraciły dotychczasową pozycję był HubPages, WikiHow oraz eHow. Pojawiły się głosy, że wprowadzone zmiany są przedłużeniem wcześniej wprowadzonych updatów, takich jak Pingwin lub Panda, jednak Google oficjalnie zdementował te pogłoski.

Jedynym sygnałem dotyczącym jego pojawienia się były zmiany w rankingach. Modyfikacje odbiegały od schematów, według których funkcjonowały poprzednie updaty. Google przyznał się do wprowadzenia zmian dopiero po pewnym czasie.

Update wziął na cel tzw. strony tag pages, czyli takie, które miały formę listy fraz i miały na celu linkować do konkretnej strony, a także artykuły niskiej jakości, mające pełnić funkcję clickbaitów, nie oferując wartościowych informacji. Zazwyczaj miały one formę kilku akapitów, które były otoczone reklamami. Niektóre witryny straciły nawet 90%. Średnia strata wynosiła około 50-60%, dlatego niektórzy stwierdzili, że Fantom to najpotężniejszy update, jeśli chodzi o surowość narzuconych kar.

Ucierpiały także strony, które zawierały wiele reklam i były zaprojektowane w taki sposób, że ciężko było po nich nawigować.

Wiele osób stwierdziło, że update Phantom był ważnym krokiem w kierunku polepszenia jakości praktyk wykorzystywanych w marketingu internetowym.

7. Aktualizacja Fred

7. Aktualizacja Fred

Nazwę algorytmowi nadał Gary Illyes, zrobił to jednak w ramach żartu i później stwierdził, że nie potwierdza wprowadzenia zmian. Mimo wszystko wielu użytkowników datuje ich wprowadzenie na 8 marca 2017 roku. Google do dziś twierdzi, że nic się nie wydarzyło, jednak wielu webmasterów uważa, że Fred miał duży wpływ na SERP. Po jego wypuszczeniu wiele stron straciło dużą część ruchu, podczas gdy inne nie ucierpiały wcale. Przetasowanie było tak duże, że w świecie SEO zapanowała panika.

Barry Schwartz odkrył, że ukarane strony mają podobną charakterystykę – są nastawione na agresywną reklamę. Na tej podstawie powstała teoria, według której Fred miał ukarać strony stawiające zarobek ponad UX (user experience – wrażenia użytkownika związane z wizytą stronie). W większości przypadków były to witryny, które stawiały duży nacisk na reklamę, zapewniając przy tym content niskiej jakości.

8. Aktualizacja Machabeuszy (Maccabees)

8. Aktualizacja Machabeuszy (Maccabees)

Nazwę zaproponował Barry Schwartz, który wybrał Maccabees ze względu na zbliżające się święto Hannukah,. Rzadko się zdarza, by Google w środku grudnia postanowił wprowadzić zmiany w swoim algorytmie. Przeważnie należy on do najspokojniejszych miesięcy, ponieważ firma stara się minimalizować ryzyko powstania chaosu tuż przed świętami, czyli w okresie największego zakupowego szaleństwa. Rok 2017 był pod tym względem inny. Na forum WebmasterWorld zawrzało po tym, jak 13 i 14 grudnia wprowadzono aktualizację.

Google nie potwierdził wprowadzenia aktualizacji, dlatego wszelkie informacje na temat jej wpływu na wyszukiwarkę to tylko spekulacje specjalistów z branży SEO. Początkowo firma nie wypowiadała się w tej sprawie, dopiero później potwierdzono, że zostało wypuszczonych kilka usprawnień, mających zwiększyć trafność wyszukiwania.

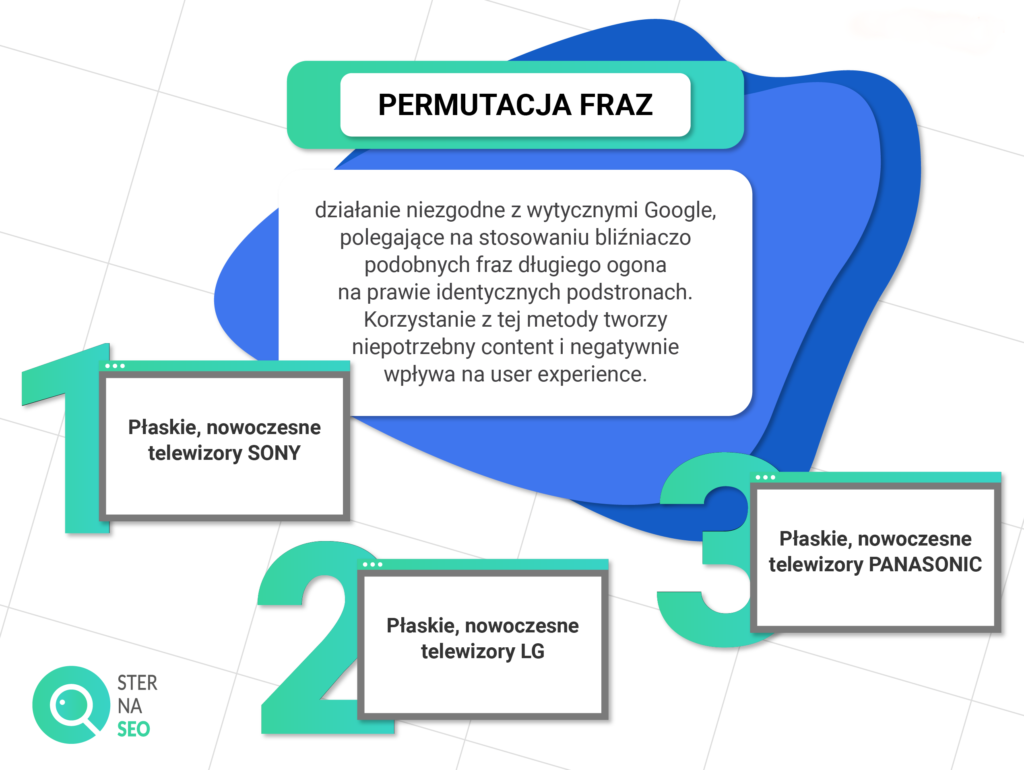

Aktualizacja wprowadziła zmiany odnośnie fraz długiego ogona, czyli takich, które składają się z co najmniej czterech wyrazów. Ich stosowanie stanowi bardzo dobrą strategię, ponieważ są one stosunkowo odporne na wahania i pozwalają wyszukiwarce lepiej sprecyzować kontekst strony. Niestety, zawsze gdy pojawiają się nowe metody pozycjonowania, znajdują się ludzie, którzy starają się wymyślić sposób, by oszukać system.

W tym przypadku zaczęto stosować permutację fraz. Ta „sztuczka” polegała na używaniu praktycznie identycznych fraz długiego ogona, na bliźniaczo podobnych podstronach. Przykładowo, sprzedając telewizory marki Sony, LG, czy Panasonic, zamiast tworzyć dla nich jedną stronę produktową, tworzono trzy z odpowiednio zmodyfikowaną frazą np. Telewizory SONY, telewizory LG itd. Powstawał w ten sposób niepotrzebny content, który obniżał UX. Właśnie takie działania karała aktualizacja Maccabees.

Niestety walka z permutacjami fraz nie jest działaniem korzystnym dla wszystkich. Istnieją branże, w których permutacje musza występować. Są to np. strony handlarzy nieruchomościami.

9. Aktualizacja Brackets

9. Aktualizacja Brackets

Nazwa tego update’u została nadana przez Glena Gabe i nawiązuje do mistrzostw koszykówki NCAA, które odbywały się w okresie, w którym wyszedł update.

Wprowadzenie aktualizacji zostało oficjalnie potwierdzone przez Google. Firma wypuściła oświadczenie, które głosiło, że nieustannie wypuszcza update’y, a niektóre z nich dotyczą głównego algorytmu. Właśnie taką aktualizację był Brackets. W wyniku jego wprowadzenia wyższe pozycje uzyskały strony, które wcześniej były niedocenione, a zawierały content wysokiej jakości.

Zgodnie z informacją zamieszczoną przez pracownika Google, strony, które spadły w rankingach nie musiały być źle zaprojektowane lub stosować zabronionych „sztuczek”. W efekcie jedyne co mogły zrobić, by odzyskać dawne pozycje, było publikowanie interesującego contentu.

10. Reasumując

Google nie zawsze informuje webmasterów o wprowadzanych zmianach, czasem odpowiada zdawkowo, w niektórych przypadkach w ogóle nie potwierdza aktualizacji lub zachowuje milczenie. Taka postawa wiąże się z modelem biznesowym firmy. Trzeba pamiętać, że priorytetem są dla niej odbiorcy, a nie webmasterzy, dlatego robi wszystko, by promować te strony, które zapewnią internautom wartościowe treści. Gdyby firma wyjawiała dokładne informacje odnośnie każdej aktualizacji, webmasterzy mogliby oszukać algorytm, opracowując drogę na skróty. Tajemnica sprawia, że najlepszym i najefektywniejszym rozwiązaniem jest przestrzeganie Wskazówek dla Webmasterów.

Pamiętajmy, że nawet tezy dotyczące update’ów lub zaledwie skrawki informacji zawsze pokazują, że update’y mają na celu wynagradzać strony posiadające content jak najwyższej jakości, a witryny stosujące agresywne techniki reklamowe albo spamerskie „sztuczki” SEO często tracą pozycję, dlatego trzeba się ich wystrzegać.

Źródła: Developing your Web presence; VirtueSeo Blog; searchblog; Ryte Wiki; Express Writers; NO-BS; Blue Corona; Modern Marketing Partners; PENNInk; SEJ; Quora; Search Engine Watch; Search Engine Roundtable; WordStream.

1.

1. 2.

2. 3.

3. 4.

4. 5.

5. 6.

6. 7.

7. 8.

8.

9.

9.